Quando si parla di smart TV o in generale dei moderni televisori, il termine HDR sembra sempre presente. La prossima TV che comprerete sarà infatti, con ogni probabilità, una TV 4K HDR, o addirittura 8K HDR. Al di là della risoluzione infatti, proprio il supporto ad HDR è divenuto negli anni sempre più importante, e continuerà ad esserlo anche in futuro. Tutti i maggior produttori lavorano per migliorare le proprie tecnologie, proponendo di tanto in tanto dei nuovi standard che fanno da cavallo di battaglia delle diverse lineup.

4K HDR – Tutti i principali standard

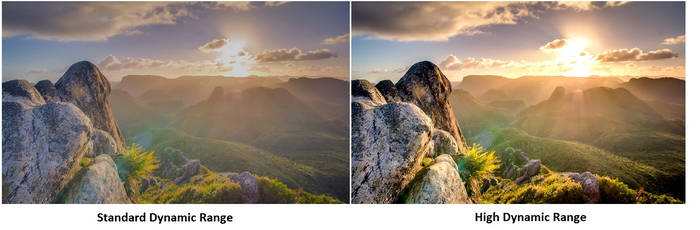

HDR sta per High Dynamic Range, una tecnologia ben conosciuta dai videogiocatori. Abbiamo iniziata a vederla anche nei nostri salotti grazie alle TV 4K HDR. L’HDR, di per sé, garantisce una differenza sensibile nei contrasti e nei colori offerti dal pannello. Elemento necessario affinché HDR funzioni è che il film, il programma o il videogame che stiamo utilizzando lo supporti (nativamente o con un successivo aggiornamento).

Il funzionamento dell’HDR è lo stesso che alcuni di voi conosceranno dal mondo della fotografia. Fondamentalmente consiste nel registrare un maggior numero di informazioni riguardo l’illuminazione di un frame (o di una fotografia), informazioni che permettono di riprodurre più dettagli sia nelle zone più chiare che in quelle più scure dell’immagine. Oltre all’incremento nei dettagli, più informazioni significa anche più tonalità e più sfumature per ciascun colore, con conseguenze non trascurabili durante la visione di un film in una TV 4K HDR. Concettualmente è come quando da bambini vi regalavano l’astuccio con 12 matite colorate mentre il vostro compagno di banco ne aveva 36.

Attenzione però, perché un eccesso di HDR potrebbe portare a un certo fastidio in determinate scene, ma a quel punto dipenderà dai coloristi durante le fasi di post produzione.

Gli standard di HDR attualmente presenti sul mercato sono HDR 10 (o Ultra HD Premium), HDR 10+, HLG e Dolby Vision. Andiamo a scoprire di che si tratta, procedendo in ordine alfabetico.

Dolby Vision: lo standard migliore per TV 4K HDR

Dolby Vision è standard supportato da alcune TV 4K HDR e 8K, qualitativamente migliore rispetto a HDR 10.

In linea teorica, Dolby Vision permette di lavorare su film registrati in 12 bit, contro i 10 bit di HDR 10. La luminosità massima punta ai 4.000 nit (10.000 dichiarati) contro i 1.000 dell’altro standard, garantendo un HDR molto più intenso e d’effetto. Il problema è che valori tanto elevati sono difficilmente raggiungibili in una TV pensata per il mercato mainstream. Al momento in cui scriviamo, le migliori TV QLED raggiungono meno di 1500 nits di picco, mentre le migliori TV OLED si fermano a circa 1000 nits. Potete approfondire nel video di presentazione dal canale YouTube di Dolby, in inglese.

Qualsiasi TV 4K HDR che supporti Dolby Vision supporterà automaticamente anche Ultra HD Premium, che è a tutti gli effetti uno standard inferiore.

HDR 10 (o Ultra HD Premium): la base di partenza

HDR 10 è la base di partenza, uno standard che identifica le TV 4K HDR. Ecco i requisiti schematizzati e poi approfonditi:

– Risoluzione minima di 3.840 x 2.160 pixel (4K o Ultra HD);

– Profondità di colore a 10 bit;

– Copertura minima del 90% dello spazio colore P3;

– Supporto HDR sulla base dei due possibili standard;

Sulla risoluzione minima non c’è davvero molto da dire, la TV deve contare minimo su una risoluzione 4K.

La profondità di colore indica fisicamente il numero di colori che la TV è in grado di processare. Attualmente la maggior parte delle TV e dei monitor sono a 8 bit, il che si traduce in 16,7 milioni di colori. Un pannello a 10 bit può processare invece 1,07 miliardi di colori.

Lo spazio colore identificato come P3 è un range di colori che assicura che quanto vediamo in TV coincide con quanto effettivamente il regista voleva che vedessimo. Viene identificato nelle specifiche tecniche dalla voce Color Gamut. Se il valore è di almeno il 90% la TV o il monitor riproduce abbastanza colori per garantire un’esperienza ottimale in 4K HDR.

Per quanto riguarda l’HDR la questione può sembrare un po’ bizzarra. Per andare incontro sia ai produttori di schermi LCD che di schermi OLED, sono stati creati due standard pensati per garantire l’HDR a prescindere dai punti di forza e dalle debolezze delle diverse tecnologie. Le TV LCD, che contano su una luminosità superiore rispetto a quelle OLED, devono dunque raggiungere uno standard di almeno 1000 nit di luminosità e un minimo di 0,05 nit sui neri. Gli OLED, che contano invece su neri assoluti, devono raggiungere uno standard di almeno 540 nit di luminosità e un minimo di 0,0005 sui neri.

HLG o Hybrid Log Gamma: da SDR a HDR

Le TV 4K HDR possono supportare, come abbiamo visto, un gran numero di standard. Uno di questi è per l’appunto HLG, acronimo di Hybrid Log Gamma. Si tratta di una tecnologia retrocompatibile, dunque in grado di funzionare anche sulle normali TV SDR. Per questo motivo HLG fa particolarmente gola alle emittenti televisive. Questo standard permette infatti di migliorare i colori del segnale SDR, ma non raggiunge gli elevati livelli qualitativi dei migliori standard HDR, come Dolby Vision e HDR 10+.

HLG è comunque una tecnologia piuttosto apprezzata e gratuita, dunque è ragionevole presumere che continuerà ad essere supportata e migliorata negli anni a venire.

Potrebbero interessarti:

- TV e monitor: guida alla comprensione delle tecnologie

- Tecnologie TV 2020-2021: HDMI 2.1 e 8K

- Migliori TV 4K HDR per film e gaming